Szendi András vendégcikke, online alkalmazások fejlesztése és adatelemzés: https://visitorgen.com/hu

A Visitorgen.com társalapítója és társfejlesztőjeként egy igen érdekes tanulmánnyal szeretnélek megismertetni, mely alapjaiban változtathatja meg a SEO szakmába vetett hitünket. A tanulmányunk nagyjából 4 hónap intenzív munka eredményét foglalja össze. Próbáljuk meg most minden eddigi feltételezésünket és tudásunkat félretenni egy pár percre és nézzük tisztalappal a tanulmány részleteit objektíven.

Itt az ideje másképp tekintenünk a találati listára

Minden weboldal tulajdonos és minden SEO szakember legfőbb célja, hogy a Google által generált találati listán minél előkelőbb helyen szerepeljen a kezelt weboldal, lehetőleg minél több keresési kifejezésre. De biztos vagy benne, hogy az egymást követő oldalak ugyan annak a találati listának folytatása? A helyzet az, hogy koránt sem. Minden oldal, vagy oldalcsoport egy önálló relevancia halmaz alapján épül fel.

Mit jelent ez pontosan?

Azt, hogy az első oldalon lévő linkek az algoritmus által meghatározott legtöbb relevancia pontját kapta meg egy osztályozási rendszer alapján. A kereséseidre itt jelennek meg a leginkább illeszkedő találatok. A weboldal teljes egésze releváns tartalommal bír a kereséssel összevetve, továbbá megfelel a Google legtöbb irányelvének.

Ha ebbe a halmazba sok weboldal is beletartozik azonos relevanciával, akkor a találati lista 1. oldala igen hosszú lehet. Sok keresés akár 50 elemből álló találati oldalt is eredményezhet. Az, hogy ezek a találati listák oldalanként csak 10-20 találatot tartalmazhatnak eleve téves, mivel ez igen változó. Ami viszont még ennél is érdekesebb észrevétel lehet, hogy a második, vagy harmadik oldal találati listája nem kötelezően tartalmaz ugyan annyi elemet, mint az első. Minden egyes oldal önálló elemszámmal rendelkezik annak függvényében, hogy a különböző oldalak által definiált relevancia halmazok mekkora terjedelműek.

Mit nem vettünk még észre?

Ez talán még önmagában nem lenne akkora jelentőségű észrevétel, viszont nem csak az elemszám változik lapozáskor. Ha jobban megfigyeljük, minden keresésnél a találati lista tetején látunk egy becslésszámot, ami azt mutatja meg, hogy az adott keresésre mennyi weboldal felelne meg. Csakhogy népszerűbb keresések esetén ez a szám akár több tíz vagy akár több százmillió is lehet. Ez a weboldalak teljes halmaza, amiben a Google keres és ebből fogja a lehető legrelevánsabbakat kilistázni számunkra. De mi van a további oldalon akkor? Megfigyelhető, hogy egyes lapozások alkalmával ez a relevancia halmaz jelentős mértékben csökkenni fog. Egy hátrébb lévő találatioldal már nem ugyan abból a relevancia halmazból fog találatokat listázni számunkra.

Vegyünk egy példát a relevancia halmazok szemléltetésre: Ha rákeresünk például a Paleo Cookbook kifejezésre (mondjuk egy amerikai IP címmel), azt fogjuk észre venni, hogy az első oldalon tényleg a paleo étel kultúrával foglalkozó szakácskönyvek lesznek felsorolva. A második oldalon főleg a paleo életvitelt körül járó tartalmak, főleg cikkek lesznek megtalálhatók. Majd, ahogy megyünk egyre hátrébb a lista következő oldalain ez a relevancia egyre kisebb lesz. Hátrébb már nem is nagyon fog megjelenni a paleo kifejezés, már elég lesz csupán az, ha szakácskönyvről, vagy főzésről van szó, holott, ha megnézzük az első oldalon még több millió releváns találatot jegyzett a Google, viszont az 50-100. helyen elhelyezkedő találatnak ehhez szinte már semmi köze sincs.

OK, de mi alapján épülnek fel ezek a relevancia halmazok?

Erre nehéz pontos választ adni, de megközelítő magyarázatot lehet. Alapvetően a relevancia halmaz különböző szempontok szerint felépített találati elemcsoportok, mely csoportokban más-más szempontok alapján relevánsak a találatok. Nézzünk meg néhány megközelítést erre.

Kereső személyek profiljai alapján

Az, hogy egy weboldal kinek és miképpen lesz releváns, ahhoz meg kell értenünk a kereső személyek szokásait, keresési előzményeit, egyszerűsítve profilját. Erről nem titok, hogy a Google elég részletes statisztikát vezet. Biztosan már neked is feltűnt például, ha rákeresel egy városra, vagy utcára, esetleg beállítasz egy útvonalat a számítógépeden, majd beülsz az autódba és szeretnéd ezt az útvonalat megtervezni, hogy a telefonod GPS-e elnavigáljon oda, szinte azonnal feldobja neked ezt a lehetőséget. Ez nem véletlen! A Google próbálja megérteni mindig az aktuális igényeidet és arra próbál minden percben reagálni. Ez a kereséseidre is igaz. Minél több keresést indítasz egy adott témában, annál jobban fogja érteni mit is szeretnél kezdeni azzal az információval, ennek pedig az a következménye, hogy egy idő után nem csak azokat a találatokat fogod látni, amelyek a weboldal népszerűségéből adódva relevánsabbnak tűnhetne, hanem azokat, ahol pontosan azt az információt kaphatod meg, amit keresel. Az, hogy ezt tényleg megkaptad-e a weboldaltól azt a tartózkodási idődből és a weboldalon végzett cselekményeidből fogja kikövetkeztetni. Az elsődleges találati lista tehát a klasszikus értelemben vett SEO tevékenységek eredménye, melyet kulcsszódús tartalommal és linképítéssel érhetünk el, viszont ezt a relevanciát felülbírálhatja a látogatók keresési szokásainak megfelelően.

Ha két egymástól független eszközről, ugyan azzal az IP címmel rákeresünk ugyan arra, úgy hogy az egyik kereső fél már keresett hasonló tartalmat, a másik fél pedig nem, akkor azt fogjuk észre venni, hogy jó eséllyel nem ugyan azt a találati listát fogjuk látni. Azok az oldalak jobb pozícióban lesznek, amelyeket már előzőleg meglátogattunk (és eltöltöttünk azon egy kritikus időt is), illetve amit a Google a legközelebbi találatnak gondol az eddigi kereséseinknek megfelelően. Tehát több keresésünk előzménye is befolyásolni fogja ezt.

És most jön a lényeg: Ennek köszönhető az, hogy a találati lista folyamatosan mozgásban van, mivel a relevancia nem kizárólag a weboldal tartalmi elemei és a keresőszavak párhuzamában kell vizsgálni, hanem a folyamatosan változó keresési szokásokban is.

Áhh ez csak Google Dance… Vagy nem?

A Google Dance a gyakorlatban egy A/B tesztelési folyamat. Ha egy weboldalnak hirtelen megváltoznak a SEO értékei, akkor a Google ki fogja vizsgálni, hogy ezt tényleg a látogatói igények generálták, vagy esetleg egy manipulációról van szó. Ekkor a Google egy kontroll csoport számára időközönként szándékosan előre hozza a weboldalt a találati listán, hogy ellenőrizze, hogy a látogatók, akik eddig nem látták a weboldalt, számukra valóban értékes az ott megtalálható tartalom. Magyarán felülvizsgálja, hogy helyes relevanciahalmazba került-e a weboldal. Ezt tudja mérni a CTR, visszafordulási arány és a munkamenet idő hosszából. Éppen ezért ezen három paraméter javítása rendkívül fontos tényezője a helyezéseink javulásában. Algoritmus frissítésekor gyakran észrevehetjük, hogy a helyezések egy rövid időszakra teljesen felborulnak. A Google ekkor teljesen új relevancia halmazokat hoz létre a frissített kiválasztási metódusának megfelelően. Ez okozza bizonyos esetekben a találati lista radikális átrendeződését. Ez idővel realizálódik a fent leírt elvek szerint.

Éppen emiatt nehéz konstansan kijelenteni, hogy egy adott weboldal pontosan hol is szerepel a találati listán egy adott keresési kifejezésre, mert ennek meghatározásához nagyon sok paramétert kell figyelembe vennünk. A pontosabb megközelítés talán inkább az lenne, hogy úgy gondolkodnánk, hogy az adott keresési kifejezésre vetített havi keresési számból, hány alkalommal kattintottak a mi weboldalunkra. Ez egy sokkal gyakorlatiasabb megközelítése a SEO tevékenységünk sikerének mérésére.

Közelítsük meg egy egyszerű példával ezt a feltételezést

Ha 2021-ben rákeresel egy 2021-ben gyártott autóra, telefonra, vagy bármilyen eszközre, jó eséllyel a relevancia a klasszikus SEO értékek alapján fog felépülni (PA, DA, stb…) értékek alapján. Ha ugyan ezt a keresést mondjuk 5 évvel később megismétled szintén a 2021-es termékek megkeresésére, már nem biztos, hogy ugyan ezeket a találatokat fogja kilistázni a Google. A példa kedvéért, most tegyük félre, hogy mert közben változik az algoritmus, vagy mert változtak a weboldalak SEO minőségi mutatói. Tételezzük fel, hogy ezek nem változnak meg ez idő alatt. Ekkor már a találati lista annak a statisztikának lesz betudható, hogy adott időszakban a kereső személy jellemzőinek megfelelően melyik weboldal nyújtotta a legtöbb hasonló profilú látogatója számára a legjobb minőségű tartalmat. Nyilván ebben lesz átfedés a jó SEO értékekkel rendelkező weboldalak között, de a találati lista elég erősen átrendeződhet a szokásoktól függően.

Ezt talán az alábbi három párhuzam vonatkozásában érdemes nézni:

- Amennyiben olyan tartalomra keresünk a Googleben, amit még eddig sosem, tehát nincs hasonló böngészési előzményünk sem, akkor a találati lista pusztán a weboldalak SEO értékei alapján fognak rendeződni.

- Ha már volt hasonló előzményünk, akkor a keresési profilunk is befolyásolni fogja ezt a listát.

- Ha pedig a keresett tartalom már nem tekinthető újdonságnak, tehát már lecsengett a téma népszerűsége és erre utólag is rákeresünk, akkor a weboldal SEO értékei mellett az átlagolt össznépi keresési szokások és az egyéni keresési szokásaink közös halmaza fogja meghatározni a találati lista felépülését.

Lokáció, vagy közösségi események befolyása

A fent vázolt relevancia harc további meghatározó tényezői a lokáció, illetve a közösségi események értelmezése. Ha rákeresünk mondjuk a kocsma szóra a keresőben, akkor jó eséllyel a hozzánk közeli kocsmákat fogja kilistázni, vagy azokat, amelyekben már tudja, hogy megfordultunk, esetleg sejti a Google algoritmusa, hogy megfordultunk (pl. véleményeztük a helyet előzőleg). Viszont, ha a Google lát összefüggést a kocsmában való focinézésben és éppen van egy EB, vagy VB mérkőzés a keresés időpontja körül, akkor nagy eséllyel olyan kocsmákat fog javasolni, ahol lehet foci meccset nézni, vagy eleve szurkolói közösség tematikájára épült a kocsma. Ezt tovább fogja tudni szűrni a Google a keresési előzményeink által. Tehát jó eséllyel nem fog egy fradistának Újpesten kocsmát javasolni. Legalábbis az első találati oldalon nem, ugyanis, ha visszakanyarodunk arra a feltételezésre, hogy az első találati oldal teljesen más relevancia halmazból válogat találatokat, mint a következő oldalak, akkor már elképzelhető, hogy ezek a kevésbé releváns találatok is megtalálhatóak lesznek, de csak hátrébb.

És mi következik ebből?

Az, hogy ha az a célunk, hogy a találati lista hátrébb lévő oldaláról előrébb jussunk az első találatioldalra koránt sem biztos, hogy pusztán linképítéssel lehetséges lesz. Sokkal több tényezőre kell hatással lenni ehhez, hogy hatékonyan új relevancia halmazba kerüljön át a weboldalunk. Ehhez nagyon sokat tesznek hozzá az egy adott téma köré épülő szöveges tartalmak és hogy ezek milyen felhasználói szokásokat és reakciókat váltanak ki a látogatókból.

Tehát a forgalom és a látogatók szokásai komolyabb tényezők lehetnek, mint a linképítés?

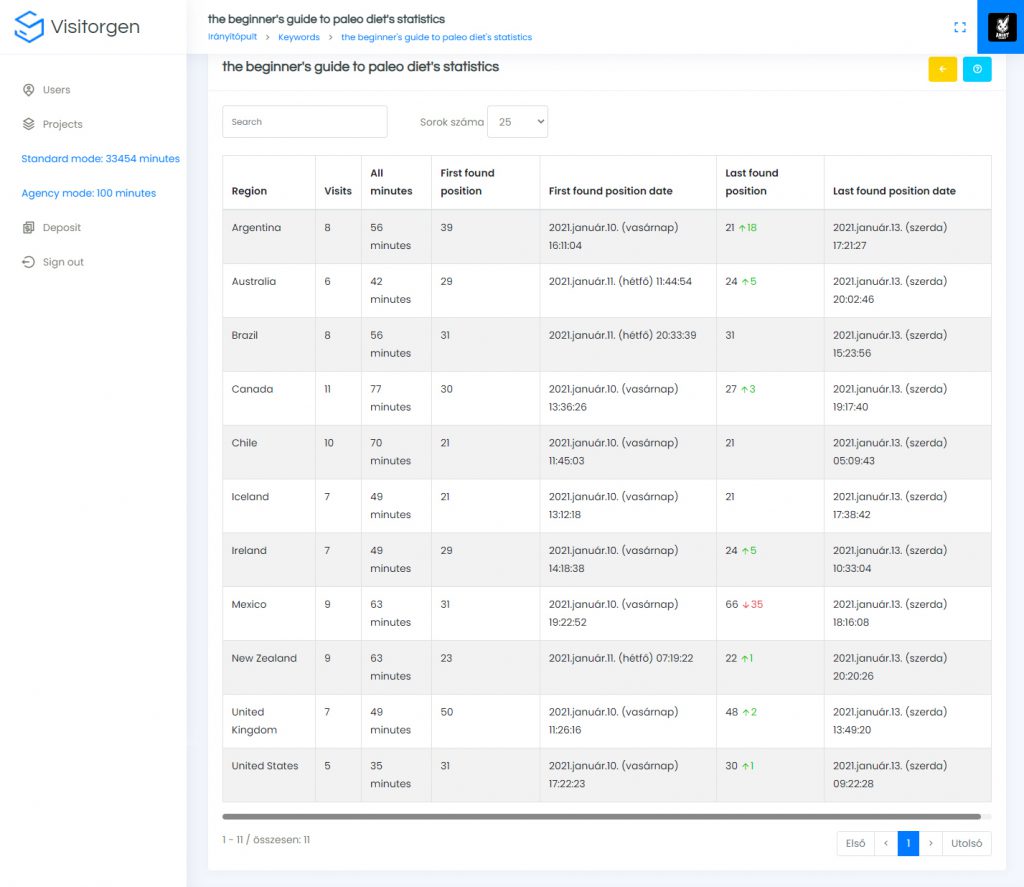

Ha jól közelítjük meg a kérdést, akkor igen. A Visitorgen projekt keretén belül számos esettanulmányt készítettünk arról, hogy szolgáltatásunknak köszönhetően forgalmat szimuláltunk általunk kezelt weboldalakra. Ennek időhosszát és intenzitását aszerint beállítva, ami nem túl elrugaszkodott és szignifikánsan feljavítja a CTR, visszafordulási arány és munkamenet idő statisztikai mutatók átlagát. Erre egy elég precíz szabályrendszert dolgoztunk ki, mely a legtöbb esetben több kulcsszó esetén is tartós helyezésjavulást eredményezett. A 4 hónapos tesztidőszakot megelőzően, 3 hónapja nem voltak ezeken a weboldalakon sem új tartalom, sem tervezett linképítés, tehát az eredmények ténylegesen betudhatóak a teszt során elvégzett folyamatoknak.

De ez mégis hogyan lehetséges? Ez tényleg működhet? Miért nem csinálta, akkor ezt már meg más is?

Mindenben vannak elsők, így ebben is, habár az ötlet nem volt újszerű. Hasonló szolgáltatást ígérnek úgynevezett traffic botok is. Viszont ezek jelentős része csak direkt forgalmat szimulál, ami nem elég a fent említett 3 statisztikai mutató együttes javulásához. Azok a botok, melyek esetleg a Google találati listájáról kattintanak szintén csak néhány másodperces tartózkodási időt garantálnak a weboldalon. Ezek ebben a formában inkább kártékonyak lesznek a helyezéseinkre, mintsem, hogy beváltsák az ígéreteiket, ezzel szemben a tanulmányban felhasznált rendszer, ezeket a hiányosságokat pótolva olyan megoldással valósította meg ezt a fajta működést, mely az Analytics és Search Console-ban is mérhető, jó eredményeket hozott. Ezt úgy értük el, hogy minden egyes keresést egyedien létrehozott és minden esetben új profillal végeztük el. Így minden látogatásunk teljesen új munkamenetnek minősült. Ezt UTM paraméterezéssel nyomon is tudtuk követni. Továbbá a meglátogatott weboldalon görgetést és egérmozgatást is szimuláltunk. Kifelé mutató linkeket és Adsense, vagy egyéb hirdetést a rendszer nem kattint le. Erre szigorú etikai normáink vannak. Ennél mélyebb technikai részletekbe nem fogunk most belemerülni, ellenben a működésének megértéséhez nézzük át, hogyan működött régen és feltételezhetően most a Google.

Hogyan működött régen a Google, amiben még ma is sokan bíznak?

A SERP (Search Engine Result Page) helyezés régebben a Markov-lánc átdolgozása nyomán alakult ki, melynek osztályozási rendszerét PageRank néven ismerhette mindenki. Azonban ez a megoldás a relevanciát kizárólag a weboldalak egymásra való hivatkozásával számolta ki. Az alapvető logika arra épült, hogy ha egy weboldalra N darab link mutat, akkor amennyiben az a weboldal máshova linkel, a link erőssége az N darab link alapján dől el. Ez összességében egy igen bonyolult gráfrendszert alkot végül. A legtöbb esetben 3D-ben szokták oszlopokkal ábrázolni az eredményt, ahol az egyes oszlopok a weboldalak és az oszlopok magassága adja meg a PageRank értéket, melynek értékét (magasságát) alapvetően az oszlopra mutató vektorok mennyisége és súlya határozza meg. A rendszert folyamatosan frissítették, ahogy a GoogleBot fejlődött és egyre több információt volt képes feldolgozni a weboldalakból egyre jobban tudta tematizálni és értelmezni a weboldalak tartalmát.

Aztán ~2010 körül a Google egy komolyabb átdolgozást jelentett be, melynek keretében a linkek mellett egyre fontosabbá vált a valós tartalom és a weboldal önálló működése. Ebben az időszakban kezdődött el azon szabályok bevezetése, hogy a betöltési idő, a szerkezet felépítése (HTML struktúra) legalább annyira fontos, mint az, hogy az adott weboldalra hányan linkelnek.

Azonban a fejlődés itt nem állt meg és minthogy a 2010-es évek a közösségi média előretörésének aranykorának számít, ez mindenre hatással volt. A Google kiemelten elkezdte figyelni a szokásokat, melynek alapvető logikája „Ha másnak érdekes, akkor neked is az lehet…” – ennek értelmében, ha egy weboldalon valaki sok időt tölt el aktívan, azt a Google úgy értelmezi, hogy a tartalom ami a weboldalon található releváns, hiszen aktívan időt csak akkor tölt el egy látogató a weboldalon, továbbá nem lép vissza új keresést indítani, ha meg is találja ott amit keres és ez talán minden eddigi szempontnál fontosabb, mivel az emberi reakcióknál szinte semmi nem írja le jobban egy weboldal relevanciáját.

Ennek tükrében az új rendszerben, három tényező befolyásolja egy weboldal besorolását és pozícióját:

- Linképítés – ami tehát továbbra is fontos, hiszen a weboldal népszerűségét befolyásolja egy részről, hogy hány helyről lehet elérni, mindemellett a linkeken keresztül átfolyó forgalom továbbra is fontos tényező. Viszont itt fontos megjegyezni, hogy a linképítés forgalomnövekedés hiányában egy pillanatnyi hypeot fog csak eredményezni (értsd úgy, hogy A/B tesztelni fogja a Google a relevanciáját), ezért van szükség a folyamatos linképítésre, azonban, ha ez az arány nagyon romlik, tehát jelentős számú linkre sem javul a forgalom, akkor a képviselt linkerő romlani fog és a linképítés a találati listára gyakorolt hatása gyengülni fog. A linkelő weboldal és a linkelt weboldal egymásra is hatással van. Magyarán a link akkor értékes igazán, ha onnan potenciális forgalom is származik. továbbá a linkelő weboldalon a mi látogatóink számára is releváns a tartalom. Ennek hiánya volt az egyik fő oka az úgynevezett linkfarmok elértéktelenedésének. Ezek a listaoldalak önmagukban nem képviseltek értéket, amik összhangban lettek volna a linkelt weboldalak tartalmával és miután a Google új keresési metódusai már nem tereltek ide megfelelő számú organikus forgalmat az átkattintások száma is erőteljesen csökkent. Mivel a Google a weboldalak teljes relevanciáját is alapul veszi már a linkerő átadásnál, így a népszerű úgynevezett PR cikkes weboldalaknak is leáldozott, melyeknek sosem volt egy egységes irányvonala, csak következetlen cikkek sora, kifelé mutató linkekkel. A hibásan felépített linképítési stratégia által is lehet nőni fog egy időre akár az organikus forgalmunk, viszont ha a látogatók számára nem releváns a tartalmunk, ahogyan a Google elsőre feltételezte volna a linkelő weboldalak tartalma alapján, ez a versenyelőny meg fog szűnni idővel.

- Weboldal minősége – ahogy már említésre került, a betöltési idő, a tartalmi felépítés, a struktúra hibátlansága mind-mind olyan szempontok, amiket a GoogeBot figyel, amikor egy weboldalt vizsgál, hiszen például a lassú, vagy rosszul formázott weboldal rossz User Experience-t szül, ami semmilyen szempontból nem jó.

- Közösségi értékelés – és ugye itt a következő tényező, ami kifejezetten a felhasználók valós élménye alapján jön ki, mondhatnánk, hogy Real User Experience alapján értékeli a weboldalt, mely egy teljesen objektív véleményt ad a weboldalról.

Alapvetően tehát ennek a 3 tényezőnek megfelelően alakul egy weboldal osztályozása jelenleg. Ebből a legtöbb SEO szakember az első tényezőt szokta priorizálni, hiszen azt lehet a legkönnyebben a weboldal módosítása nélkül manipulálni. A második tényező esetében tartalmi felépítést szokták korrektúrázni a legtöbben, de a betöltési idő és szerkezeti felépítmény javításához már a webfejlesztőre is szükség szokott lenni, aki vagy elérhető és meg is csinálja, vagy nem (ez a jellemzőbb), így ez kérdéses pont. Azonban a harmadik tényezővel szinte senki nem tud mit kezdeni, de kifejezetten nincs is rá bevált metodika, hogy azt, hogy lehetne javítani.

Mi van akkor, ha kimagaslóan jók a SEO értékeid és jók a tartalmaid, de még sem vagy mindenre az első oldalon?

Talán ez a kérdés foglalkoztat mindenkit igazán. Próbáljuk meg ennek az okát is megfejteni a fenti tanulságok alapján.

Hallottál már az amőba elvről?

A régebbi oszlopos megjelenítés helyett az új térképezési szempontok jobb értelmezése értelmében az oldalakat már sokkal inkább amőba formát tudunk elképzelni egy weboldalnak, mely reprezentálja, hogy az oldal milyen kvalitásokkal rendelkezik SEO terén. Az amőba tulajdonságai írják le a weboldal egyes értékeinek állapotát:

- A linképítés eredménye az amőba méretében látszik, mint a régebbi PageRank-re épülő rendszer esetében, csak itt nem az oszlop, hanem az amőba méretét adja meg.

- A weboldal minősége az amőba mozdíthatóságát adja meg, tehát összességében azt, hogy mennyire könnyű, vagy nehéz előre mozdítani a találati listán a weboldalt.

- A közösségi értékelés pedig az amőba formáját adja meg, amely egészséges formában nagyjából egységes lábakkal rendelkezik.

A megfigyelések alapján a Google szereti priorizálni egy-egy weboldal tartalmát, így lehetséges az, hogy bizonyos aloldalak lényegesen előrébb, vagy hátrébb jelenhetnek meg a keresőben, mint más oldalak még akkor is ha szerintünk mindkettőnek egyforma a relevanciája az adott témára.

Például, ha egy weboldalon van 3 cikk melyeknek nincs egymáshoz köze, de az egyik cikk kimagaslóan nagy forgalommal rendelkezik, míg a másik 2 kevésbé akkor a relevancia miatt a Google elsődleges céltémának a weboldalon a látogatottabb cikk témáját fogja megjelölni. Ez azzal jár, hogy a másik két cikk kevésbé lesz releváns a céltémához képest, így míg a céltémaként megjelölt aloldal szárnyal a keresőben, a többi nem, sőt akár eléggé gyengén is szerepelhet, annak ellenére, hogy minőségben és egyéb tényezőkben nincs kifejezetten nagy különbség köztük.

Egy átlagos, jól optimalizált weboldal egyforma méretű lábakkal rendelkezik – ebből adódóan nem szignifikáns a különbség az egyes aloldalak relevanciája között, ezt a legtöbben úgy szokták „megélni”, hogy vagy minden link „hátul van” a keresőben, vagy mindegyik „elől”. Ezt ugye az amőba mérete tudja befolyásolni.

Azonban amennyiben az egyik oldalon felfut a látogatottság akkor egyértelműen elindul a relevancia skálán is előre, így az az ág el kezd kiemelkedni a többi ág közül, az amőba adott lába elkezd nagyobb lenni, ekkor azonban egy érdekes dolog történik, mivel a többi láb elkezd kevésbé releváns lenni. Ennek egyszerű az oka, a Google azt az aloldalt kezdi el priorizálni (céltémának kiemelni) a felhasználói szokások alapján, így azonban a többi oldal a weboldal témájának megfelelően visszább esik. Ez alól egyetlen kivétel, ha azokon az oldalakon is felfut a látogatás, ekkor természetesen azok az oldalak is jobban kinyúlnak. Amennyiben pedig arányosan fut fel a látogatás minden oldalunkon akkor az amőba mérete kezd el nőni.

Ez tehát végeredményképpen egy komoly relevancia eltolódást idézhet elő a weboldalon belül, mely könnyen orvosolható azzal, hogy kb. azonos relevancia érték növeléseket kell minden aloldalon elérni, még akkor is, ha a weboldal egyes aloldalai más-más témára jöttek létre (pl.: általános blog oldal, vagy általános webshop).

Egy egyszerű példával élve: Ha adott egy weboldalad, amin kizárólag a kutyákról írtál eddig. A linképítésed is főleg ezzel a témával releváns weboldalakról származik, akkor a weboldalad relevanciáját rontani fogja, ha egyszer csak elkezdesz ugyan erre a weboldalra cicás tartalmakat is feltölteni és azokat a cikkeket sikerül nagyobb sikerrel optimalizálni. Ez ugye felborítja az addigi relevancia értékeket az oldalon, így biztosítani kell a megfelelő felhasználó számot a kutyás cikkek frontján is, így mind a kutyás, mind a cicás tartalmaid jó helyezést érhetnek el a találati listán.

A szigorúan tematikus weboldalak pontosan ezért tudnak eredményesebbek lenni a találati listán az általános témákat feldolgozó weboldalakkal szemben.

Tehát, ha minél szélesebb területen publikálsz cikkeket, akkor minél szélesebb területről kell linket építened hozzá, hogy az weboldalad egységesen minden témára erősödni tudjon, ellenkező esetben akár ronthatsz is a relevanciádon azzal, hogy szélesebb témakört próbálsz lefedni. Ennek lehet később az az eredménye, hogy bizonyos kulcsszavaid nagyon előre tudnak jönni a találati listán, ellenben a kevésbé releváns tartalmaid pedig hátrasorolódhatnak nagyjából arányos mértékben, azaz az amőba egyes lábai kinyúlnak, míg más lábak visszahúzódnak.

Összegezve a régebbi PageRank alapú értékelés nem szűnt meg teljesen, így természetesen a régóta bevált technikák továbbra is fontosak maradtak, mint a linképítés, azonban a közösségi igényeknek való megfelelés két olyan tényezőt adott hozzá a folyamathoz, mely a mai rendszert sokkal inkább a már felvázolt amőba formára vezethető vissza.

A helyezésjavulás linképítés nélkül is elérhető?

A Visitorgen tanulmánya és speciális szolgáltatása alapján lehetséges, abban az esetben, ha a legkülönfélébb profillal rendelkező kereső felhasználók minél nagyobb halmaza hajlandó a te weboldaladat meglátogatni és azon szignifikáns időt eltölteni, ezzel egyre szélesebb relevancia halmaznak lesz megfelelő a weboldal ajánlása a Google szemszögéből nézve, így a relevancia értékét folyamatosan növeli annak. Tehát ha egy weboldalnak javul, a CTR értéke, visszafordulási aránya és az átlagos munkamenet ideje, akkor egyre több relevancia halmazba tud bekerülni és azokban a halmazokban egyre előrébb tud kerülni, ami elősegíti a találati lista előkelőbb helyeinek tartós megszerzését is a releváns kulcsszavakra. Feltéve, ha a Google A/B tesztelési folyamatának kiváltott időszakában olyan minőségű tartalmat biztosítunk az új látogatóink számára, amit ők is értékesnek találnak. A linképítés és minőségi irányelvek betartása pedig ettől még továbbra sem lesz elhanyagolható, csak egyre fontosabb lesz a linkek relevanciája is.

Összegezve

Ideje sokkal összetettebb összefüggésekben is gondolkodnunk a sikeres SEO stratégiánkat illetően, mint a linképítés egyszerű síkja. Ha érdekel a teljes tanulmány a mélyebb technikai részletekkel, a visitorgen.com weboldalon megtalálhatod magyar és angol nyelven egyaránt. Nektek mi a véleményetek ezekről az összefüggésekről? Tapasztaltatok hasonlókat?

Végre eljutottunk eddig, mármint addig hogy ezeket az összefüggéseket valaki meg is tudta érthetően fogalmazni.

2016 környékén kísérleteztünk hasonló területen, és ennyire látványos eredmények akkor nem lettek, de meglepőek igen (akkor nehány projektnél a technikai SEO sokkal nagyobb hatást váltott ki, mint a többi módszer)

Két észrevételem van, egyeztessük tapasztalatainkat, ismereteinket:

1.) Írod: „a találati lista tetején látunk egy becslésszámot, ami azt mutatja meg, hogy az adott keresésre mennyi weboldal felelne meg”.

Eddig én úgy tudtam, hogy ez a szám nem a honlapok számát, hanem a keresett szó/kifejezés fellelhetőségének számát jelenti.

2.) Írod továbbá, hogy ez a szám „egyes lapozások alkalmával” változik.

Ez egy komoly bizonytalansági tényező, mert miért van az, hogy egyes lapozások alkalmával igen, máskor viszont nagyon nem. Erre a bizonytalansági tényezőre lehet-e építeni?

Próbálok sorrendben válaszolni a kérdéseidre:

1.)

Az a találati szám, nem a keresett szó fellelhetőségét adja meg, hanem a relevancia halmaznak a méretét adja. Gyakorlatban a potenciális weboldalak számát.

2.)

Ezt igyekeztünk úgy fogalmazni a cikkben, hogy nem feltétlen jelent a lapozás új relevancia halmazt. Ha a relevancia halmaz mérete elég nagy akár több oldalon keresztül ugyan abban a halmazban böngészel. Ezért nem változik ez a szám minden esetben egyik oldalról a másikra. Ellenben ha elég messzire lapozol garantáltan változni fog ez a szám és egyre kisebb lesz. Ez önmagában nem bizonytalansági tényező, csak egy tény.

Érdemes volt felvetnem a témát, mert így utána kellett néznem a válaszodból a találati számnak – és így revidiálhatom álláspontomat (másként fogalmazva elvethetek egy tévhitet).

(Mellesleg persze azt is látom, hogy nagyon nem mindegy idézőjel között keresni a több tagból álló kifejezéseket, vagy anélkül – mert például a konkurens oldalak megtalálása vagy mennyiségük megállapítása idézőjel nélkül nagyon-nagyon elcsúszhat.)

Szóval köszönet a cikkért és a párbeszédért!